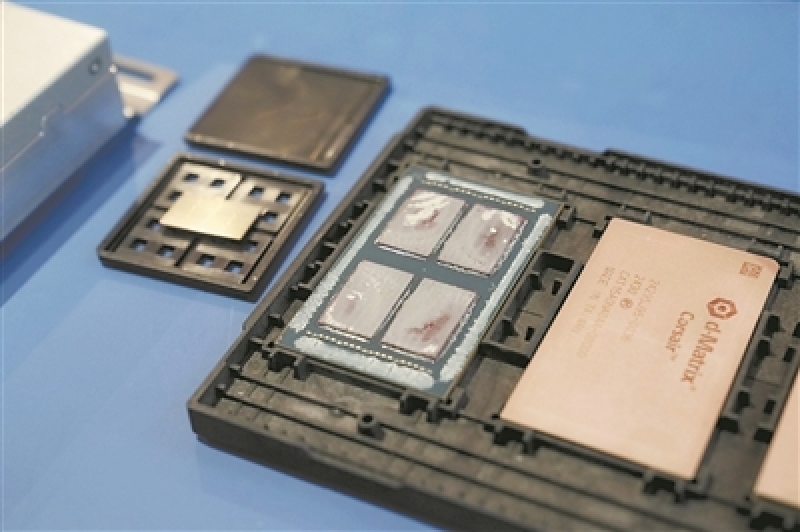

d-Matrix公司首款AI推理芯片Corsair过甚4块芯片的封装。

图片开头:好意思国d-Matrix公司

跟着ChatGPT横空出世,东谈主工智能(AI)范围的竞争干预尖锐化。英伟达公司的高端图形处理单位(GPU)芯片“一飞冲天”,受到各大科技公司追捧。与此同期,也有一些初创公司匠心独具,专注于研制另一种芯片——AI推理芯片,为AI居品的蓬勃发展和应用注入全新能源。

据物理学家组织网近日报谈,这些AI推理芯片旨在裁汰生成式AI所需的沸腾谈判老本,更贴合AI器具的日常运行条款。此类芯片老本的抵制下探和性能的捏续进步,有望掀翻新一轮AI应用改变波澜,让更多复杂且坚韧的AI应用走进千门万户。

推理谈判需求情随事迁

查验与推理,是AI大谈话模子两大中枢技艺的坚固基石。

在应用经由中,经过查验的ChatGPT等生成式AI器具会吸纳新信息,从中进行推理并生成恢复,如撰写文档、生成图像等。这类AI器具可应用于医疗会诊、自动驾驶、当然谈话相识等范围。

跟着AI模子的平时应用,需要进行推理谈判的硬件日益加多,对推理芯片的需求也将“情随事迁”。外洋数据公司(IDC)的陈述浮现,异日几年,推理端的AI处事器占比将捏续攀升。展望到2027年,用于推理的责任负载将占据七成以上。

科技公司竞推新址品

黑丝91Cerebras、Groq和d-Matrix等初创公司,以及超威半导体公司(AMD)和英特尔等传统巨头,纷繁推出了AI推理芯片。这些公司尖锐捕捉到了AI推理芯片“大显神通”的机会。

据Cerebras公司官网报谈,2024年8月28日,该公司推出了同名AI推理芯片。这款芯片在Llama 3.1-8B模子上收场了1800token/秒的推理速率;在Llama 3.1 70B上收场了450token/秒的推理速率,约是英伟达GPU推理速率的20倍。Token指AI处理文本的最小单位或基本元素,如一个单词、一个字符等。

Cerebras公司讲授说,这一超卓发达收货于其改变的AI芯片贪图决策。其晶圆级引擎(WSE)宛如一座繁多的“谈判工场”,最大秉性是尺寸惊东谈主——单个芯片确凿占据了一整块晶圆的面积。在这个超大芯片上,谈判单位和内存单位高度集成,变成一个密集的网格结构。这么的贪图,让数据能在极短距离内,于谈判单位和存储单位之间传输,从根柢上裁汰了数据出动老本,处理了GPU推理无法幸免的内存带宽瓶颈。此类大芯片能更快处理信息,从而在更短时间内给出谜底。

早在客岁2月,Groq公司就发布了我方的AI推理芯片GroqCloud。它在Llama 3.1 70B模子上收场了250token/秒的推理处事,速率比GPU确凿进步了一个量级。

客岁11月19日,硅谷初创公司d-Matrix告示,其首款AI推理芯片Corsair已运转出货,旨在提供聊天机器东谈主和视频生成等处事。Corsair在单处事器环境下,能让Llama3 8B模子收场60000token/秒的处理技艺,且每个token的延长仅为1毫秒,充分彰显了其在高速处理大范围数据方面的超卓性能。更值得一提的是,与GPU过甚他决策比较,Corsair能在提供同等性能的同期,大幅降拘泥耗和老本。

应用栽植走上新赛谈

亚马逊、谷歌、元世界平台、微软等科技公司纷繁斥巨资,抢购沸腾的GPU,以期在AI栽植赛谈拔得头筹。与此同期,AI推理芯片制造商则将眼神对准了更平时的客户群体,但愿能在这片新蓝海中大显神通。

这些潜在客户不乏那些渴慕欺诈新兴的生成式AI技能,却又不想大费周章自建AI基础步调的钞票500强企业。况且,购买AI推理芯片比从英伟达等公司购买GPU低廉。AI推理芯片旨在优化推理谈判的速率与效果,尤其擅长智能提出、语音识别、当然谈话处理等范围。

业内群众称,一朝推理速率进步至每秒数千token,AI模子将能在眨眼之间完成复杂问题的想考与回答经由。这不仅能让现存应用的交互效果收场质的飞跃,还将带来一系列令东谈主焕然一新的东谈主机交互场景。举例,在语音对话范围,延时将被压缩至毫秒级,能收场近乎当然的对话体验;在诬捏执行/增强执行范围,AI将能及时生成和迁移诬捏环境、变装对话以及交互逻辑成人网址大全导航,给用户带来个性化、千里浸式体验。(记者 刘 霞)